この記事の要約

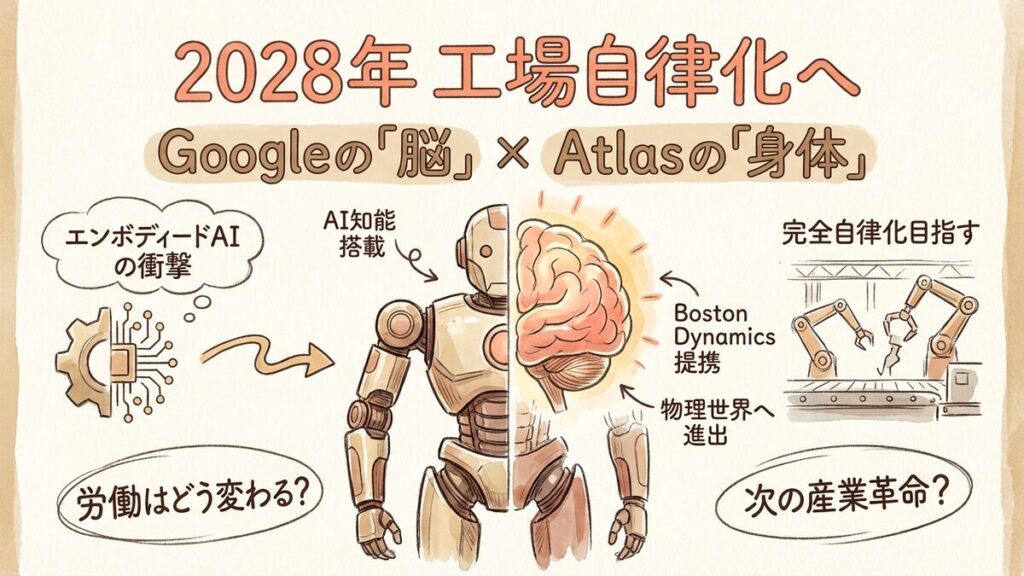

- GoogleのAI技術とBoston Dynamicsのロボット「Atlas」が提携を発表。

- 世界最高峰の身体能力に高度な知能を搭載し、完全自律化を目指す。

- 2028年までにHyundai系工場へ導入、製造現場の景色が一変する可能性。

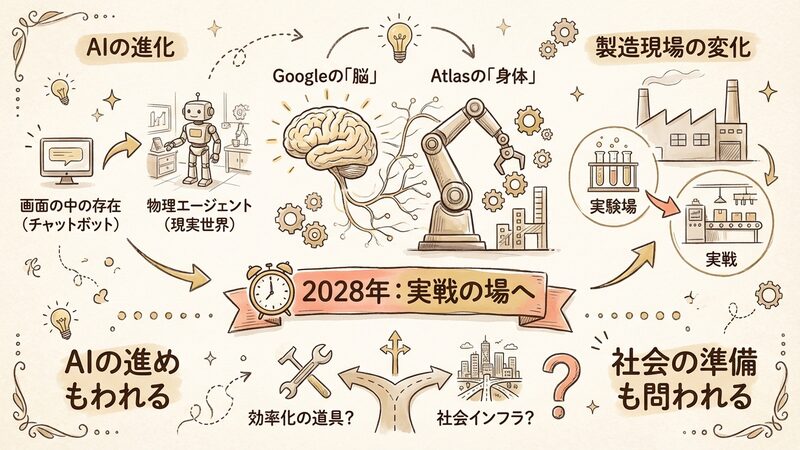

ついに、AIがデジタルの画面から飛び出し、物理世界で「手足」を持つ瞬間が訪れようとしています。世界最高レベルの身体能力を持つ人型ロボット「Atlas」と、Googleが誇る最先端AIモデルが融合するというニュースは、単なる企業間の提携を超えた歴史的な転換点と言えるでしょう。

生成AIブームで「脳」が急速に進化する一方、物理的な作業を行う「身体」との統合は技術的な壁が高いとされてきました。しかし、この提携は2028年という具体的な期限を切り、製造現場での実用化フェーズへの突入を宣言しました。これは私たちの働き方、そして産業のあり方をどう変えていくのでしょうか。

最強の身体に最強の頭脳が宿る衝撃

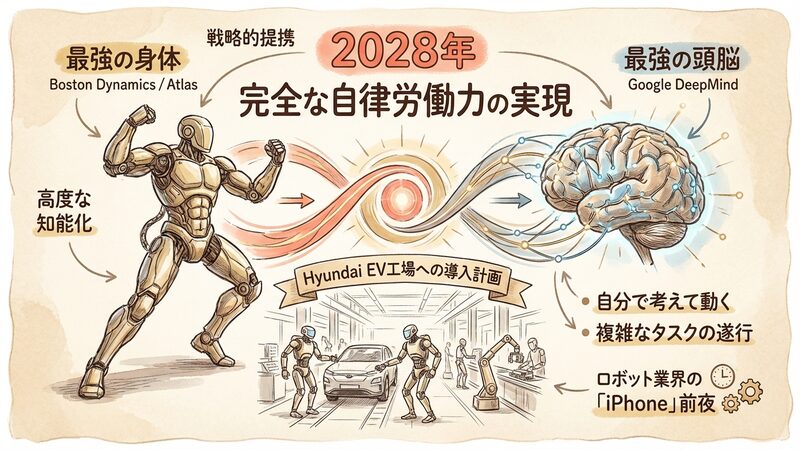

今回のニュースは、ロボット業界にとって「iPhone登場」前夜のようなワクワク感があるね。Google DeepMindとBoston Dynamicsが手を組んだんだ。

Boston Dynamicsって、あのバク宙したりダンスしたりするロボットの会社ですよね? Googleと組むって、どういうことですか?

そう、あの「Atlas」だよ。彼らはものすごい身体能力を持っているけど、これまでは人間が細かく動きを調整するか、決まった動作しかできなかった。そこにGoogleのAIという「脳」が入るんだよ。

身体と脳……それって、最強じゃないですか! 自分で考えて動けるようになるってことですか?

その通り。しかも今回は研究室の話じゃない。Hyundaiの工場で実際に働かせるという明確なゴールがあるのがポイントだね。

なるほど、ショーとして見せるんじゃなくて、本当に仕事をするための提携なんですね。

今回の提携における主要な事実は以下の通りです。

- Boston DynamicsとGoogle DeepMindが戦略的提携を発表。

- 人型ロボット「Atlas」にGoogleのAIモデルを搭載し、高度な知能化を図る。

- 2028年までに、ジョージア州にあるHyundai傘下のEV工場へ導入する計画。

- 目的は、製造現場における「完全な自律労働力」の実用化と、複雑なタスクの遂行。

ロボット新時代を読み解く5つの鍵

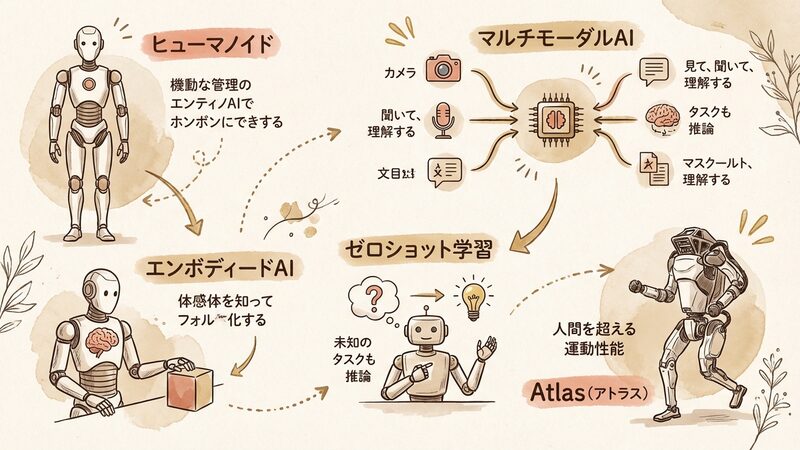

| 用語 | 解説 |

|---|---|

| ヒューマノイド | 人間のような形状(頭、胴体、2本の腕と脚)を持つロボット。人間用に設計された環境や道具をそのまま使える利点がある。 |

| エンボディードAI | 「具現化されたAI」。コンピュータの中だけでなく、物理的な身体(ロボット)を持ち、現実世界と相互作用しながら学習するAIのこと。 |

| マルチモーダルAI | テキスト、画像、音声、動画など、複数の種類のデータを同時に処理・理解できるAI。人間のように「見て、聞いて、理解する」ことが可能。 |

| ゼロショット学習 | 過去に学習したことのないタスクやデータに対しても、既存の知識を応用して推論・対応できるAIの能力。 |

| Atlas(アトラス) | Boston Dynamics社が開発した人型ロボット。油圧式から電動式へ進化し、人間を超える運動性能とバランス感覚を持つことで知られる。 |

Ads by Google

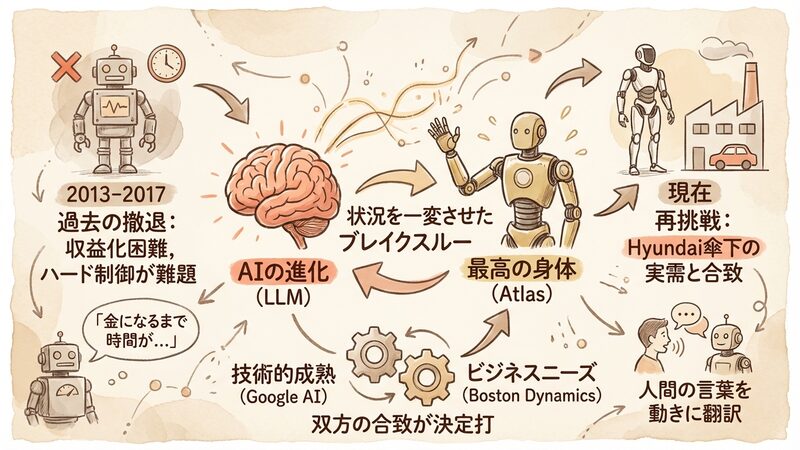

なぜGoogleは「一度手放した」ロボットに再挑戦するのか

ちょっと疑問なんですけど、Googleって昔、ロボット事業をやってませんでしたっけ?

よく知ってるね。実は2013年にBoston Dynamicsを買収したことがあるんだ。でも、2017年にソフトバンクへ売却してしまった。当時は「金になるまで時間がかかりすぎる」と判断されたんだよ。

えっ、一度手放した会社とまた組むんですか? なんで今さら?

AIの進化が状況を一変させたからさ。昔はロボットに「コップを取れ」と教えるだけで、膨大なプログラムコードを書く必要があった。ハードウェアの制御が難しすぎたんだ。

今は違うんですか?

今はLLM(大規模言語モデル)があるからね。AIが人間の言葉や画像を理解して、それをロボットの動きに翻訳できるようになった。ソフトウェア側からのブレイクスルーが起きたんだよ。

なるほど! ロボットの身体を作るのは大変だけど、頭脳が急に賢くなったから「今ならいける」ってなったんですね。

Googleにとって、今回の提携は単なる出戻りではありません。かつてはハードウェアの維持管理や収益化の難しさに直面し撤退しましたが、生成AIブームにより知能という武器を手に入れました。Google DeepMindのAIモデルを物理世界でテストするための「最高の身体」として、再びAtlasが必要になったのです。

一方、Boston Dynamicsは現在Hyundaiグループの傘下にあり、自動車工場という巨大な実需を抱えています。研究開発企業から実用化企業へと脱皮を図る彼らにとって、GoogleのAIによる自律化は渡りに船でした。この「技術的成熟」と「ビジネスニーズ」の合致が、再提携の決定的な背景にあります。

視覚と言語を繋ぎ、即座に行動する「即応力」

頭が良くなるって、具体的に工場で何ができるようになるんですか? 今のロボットと何が違うんですか?

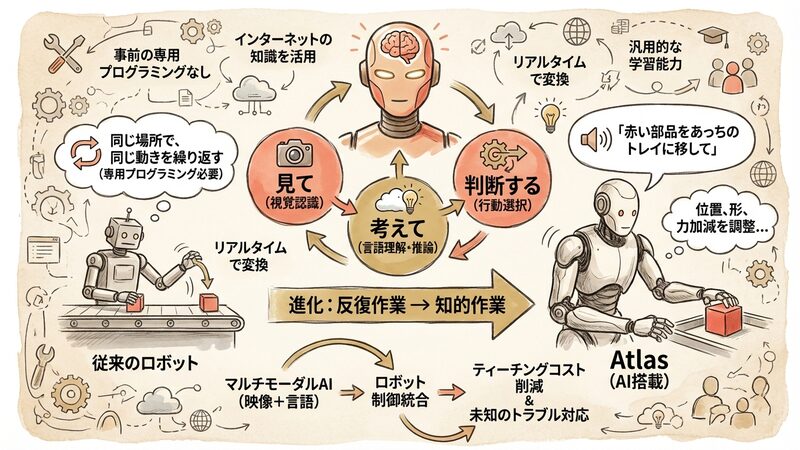

従来の工場ロボットは「同じ場所で、同じ動きを繰り返す」のが得意だった。でも、Atlasは「見て、考えて、判断する」ことができるようになる。

例えばどういうことでしょう?

「その赤い部品をあっちのトレイに移して」と指示されたら、カメラで見て、部品の位置や形を認識し、力加減を調整して運ぶ。これを事前の専用プログラミングなしでやろうとしているんだ。

えっ、教えなくてもできるんですか?

GoogleのAIはインターネット上の膨大なデータで学習しているから、「部品」や「トレイ」という概念を知っている。それをAtlasの動きにリアルタイムで変換するんだ。未知のトラブルにも対応できるかもしれないよ。

この提携の核心は、マルチモーダルAIとロボット制御の統合にあります。GoogleのGeminiなどのモデルは、映像と言語を同時に処理できます。これにより、ロボットは周囲の状況を見て「何が起きているか」を理解し、その場の状況に応じた最適な行動を選択できるようになります。

これまでロボット導入の障壁となっていたのは、環境が変わるたびに発生するティーチング(再教育)コストでした。しかし、AIによる汎用的な学習能力があれば、ロボットは初めて見る部品でも扱い方を推論したり、人間と自然言語で連携したりすることが可能になります。これは製造業における「自動化」の定義を、単なる反復作業から知的作業へと書き換えるものです。

産業革命以来の転換点?期待と不安の交差点

さて、ここで少し視点を変えてみよう。この技術が完成したら、誰が喜んで、誰が困ると思う?

工場の人たちは楽になりますよね。危険な仕事をしなくて済むし。でも……仕事が奪われる心配はないんですか?

その通り。経営者や投資家から見れば、24時間文句も言わずに働き、学習して効率を上げていくロボットは夢のような存在だ。人手不足の解消と生産性向上は間違いない。

働く側としては複雑です……。私の仕事もロボットに代わられるのかな。

労働者の視点では、確かに単純作業の雇用は減る可能性がある。ただ、ロボットをメンテナンスしたり、AIを監督したりする新しい仕事も生まれるはずだ。それに、重労働や有害な環境からの解放は大きなメリットだよ。

他の会社はどうなんでしょう? Googleだけがすごいんですか?

いや、競争は激化しているよ。イーロン・マスク率いるTeslaの「Optimus」や、OpenAIと組んでいるFigure AIなど、ライバルも必死だ。誰が最初に「使えるロボット」を出すか、国家レベルの競争になっているんだ。

このニュースを多角的に捉えると、以下のような視点が見えてきます。

- 経済・経営の視点:先進国で深刻化する労働力不足(人手不足倒産など)に対する切り札です。初期投資は高額でも、長期的には人件費の抑制と稼働率の最大化により、企業の利益構造を劇的に改善する可能性があります。

- 技術競争の視点:スマホの次のプラットフォーム覇権争いです。GoogleはAndroidでスマホ市場を席巻したように、ロボットの知能OSを支配しようとしています。対するTeslaは、自社工場という実験場と自動運転データを武器に垂直統合で挑んでいます。

- 社会・倫理の視点:物理的な力を持つAIの安全性(暴走リスク)や、雇用の流動化に対するセーフティネットの議論が急務です。「ロボット税」のような新たな制度が必要になる時代が来るかもしれません。

2028年、ロボットは同僚になっているか

2028年って、あと数年ですよね。本当にそんなに早く実用化できるんですか?

工場という限定された環境なら可能性は高いよ。床は平らだし、扱う物も決まっているからね。でも、家の中で家事をしてくれるようになるには、まだ時間がかかるかな。

失敗して暴走したりしないかな……ちょっと怖いです。

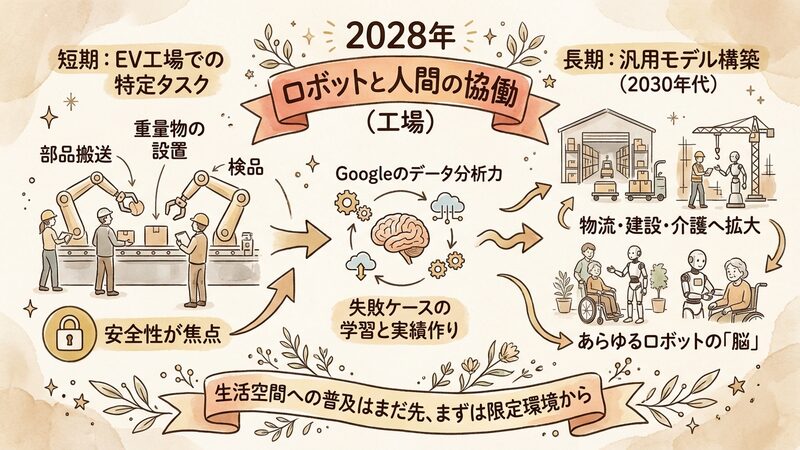

だからこその実証実験だね。Googleのデータ分析力で、失敗ケースを徹底的に学習させるはずさ。まずは工場で実績を作って、安全性を証明してからだね。

じゃあ、私たちが街中で見かけるのはもっと先なんですね。

そうだね。でも、2030年代には物流倉庫や建設現場、介護施設へと広がっていくかもしれない。この数年が勝負だよ。

今後の展望として、短期的にはHyundaiのEV工場における特定タスク(部品搬送、重量物の設置、検品など)から導入が始まります。ここでは、人間とロボットが同じ空間で働く「協働」の安全性が最大の焦点となります。

長期的には、この提携で得られた膨大な動作データが汎用ロボットモデルの構築に繋がります。Googleが目指すのは、特定のロボットだけでなく、あらゆるロボットを動かせる「脳」を作ることでしょう。もしこれが実現すれば、ロボット産業のエコシステムは爆発的に拡大し、私たちの生活空間にも自律型ロボットが入ってくる未来が現実味を帯びてきます。

デジタルとフィジカルの境界が消える日

Googleの「脳」とAtlasの「身体」の融合は、AIがチャットボットのような画面の中の存在から、現実世界に物理的な影響を及ぼすエージェントへと進化する象徴的な出来事です。2028年というターゲットイヤーに向け、製造現場は実験場から実戦の場へと変わります。

私たちは今、SF映画で見た未来の入り口に立っています。この技術が単なる効率化の道具で終わるのか、それとも社会構造を変える新たなインフラとなるのか。技術の進化だけでなく、それを受け入れる社会の準備も問われることになるでしょう。